Noindex: Unterschied zwischen den Versionen

(Die Seite wurde neu angelegt: „== Was ist der noindex-Befehl? == Die Angabe noindex ist ein Befehl, der im HTML-Code einer Website im Robots Meta Tag gesetzt werden kann und d…“) |

(kein Unterschied)

|

Version vom 27. August 2018, 13:26 Uhr

Inhaltsverzeichnis

Was ist der noindex-Befehl?

Die Angabe noindex ist ein Befehl, der im HTML-Code einer Website im Robots Meta Tag gesetzt werden kann und die Crawler von Suchmaschinen wie Google, Bing und Yahoo anspricht. Finden sie das Attribut in den Meta Tags, wird die jeweilige Seite nicht in den Index der Suchmaschinen aufgenommen und dementsprechend dem User nicht in den Suchergebnislisten anzeigt. Das Gegenstück zu noindex ist das Attribut index, welches die Indexierung explizit erlaubt.

Der Webmaster entscheidet für jede einzelne Unterseite einer Webpräsenz, ob diese Seite in den Index der Suchmaschinen aufgenommen werden soll oder nicht. Über noindex lässt sich daher die Indexierung jeder einzelnen Unterseite mit geringem Aufwand gezielt steuern, weshalb der Befehl ein wichtiges Instrument der Suchmaschinenoptimierung (SEO) darstellt. Google hält sich stets an diesen Befehl. Das gegenteilige Attribut index werten die Crawler hingegen nur als Empfehlung.

Wozu wird der Befehl eingesetzt und wann macht er (keinen) Sinn?

Mithilfe der noindex Angabe lassen sich Seiten, die dem Nutzer in den Suchergebnissen wenig bis keinen Mehrwert liefern würden, aus dem Index von Suchmaschinen ausschließen. Dazu zählen zum Beispiel Sitemaps oder die Ergebnisse der seiteninternen Suchfunktion. Auch Unterseiten mit sensiblen Daten oder durch ein Passwort geschützte Download- und Mitgliederbereiche lassen sich auf diesem Weg von der Indexierung ausschließen.

Bei Seiten mit doppelten, ähnlichen oder paginierten Inhalten ist die Indexierung im Hinblick auf die SEO ebenfalls nicht immer empfehlenswert. Durch den Ausschluss dieser Inhalte nimmt Google sie nicht als Duplicate Content wahr und die einzelnen Unterseiten treten im Ranking nicht in Konkurrenz zueinander. Dies kann zum Beispiel bei den Kategorien von Online-Shops sinnvoll sein. Lassen sich die angebotenen Produkte nach verschiedenen Kriterien sortieren, entstehen immer wieder Überschneidungen. Kann der Nutzer in einem Shop für Bekleidung beispielsweise eine überschaubare Menge an Artikeln nach Größe sortieren, erscheinen Produkte, die in mehreren Größen vorrätig sind, in mehreren Kategorie-Darstellungen. Werden diese Seiten von der Indexierung ausgeschlossen, leidet das Ranking der Webpräsenz nicht unter der Dopplung, was für die SEO vorteilhaft ist. Allerdings ist in diesem Zusammenhang zu beachten, dass durch den noindex Befehl auch die Relevanz dieser Seiten, welche beispielsweise aufgrund von Backlinks u.ä. entsteht, verloren geht. Bei Duplicate Content sollte deshalb immer der Canonical Tag verwendet werden, da dieser die Link Power der betroffenen Seiten auf die kanonische URL bündelt und gleichzeitig dem Google Bot signalisiert, welche Seite in den Index aufgenommen werden soll.

Weiterhin werden bei langen Texten oder Bilderserien häufig Paginationen eingesetzt. Hier kann es unter Umständen aus inhaltlichen Gründen Sinn machen, nur die erste Seite zu indexieren. Damit landet der Nutzer etwa bei einer Bilderserie über Suchmaschinen nicht mitten im Content, sondern am Anfang. Allerdings ist die Verwendung von noindex in diesem Zusammenhang nicht immer sinnvoll. Gerade lange redaktionelle Artikel enthalten nicht nur auf der ersten Seite Informationen, nach denen ein Nutzer suchen kann. Der Ausschluss der Folgeseiten kann daher unnötige Traffic-Einbußen nach sich ziehen, was sich negativ auf die SEO auswirken kann. Stattdessen ist bei einer Pagination die Verwendung von rel=”next”/”prev” empfehlenswert.

Möglichkeiten der Implementierung

In den Meta Angaben wird die noindex Anweisung dem robots Meta-Tag zugeordnet. Dieser enthält Anweisungen für die Crawler von Google und anderen Suchmaschinen. Zum Ausschluss einer Seite aus dem Suchmaschinenindex wird im Header des Quelltextes folgender Tag integriert:

<meta name="robots" content="noindex">

Statt alle Crawler abzuweisen, können in dem Meta Tag auch ausgewählte Suchmaschinen adressiert werden. Wer den Crawler von Google an der Indexierung einer Unterseite hindern will, ersetzt beim Attribut name den Befehl durch "googlebot". Der Name des Yahoo-Bots lautet "slurp". In der SEO Praxis macht es jedoch kaum Sinn, nur einzelne Bots auszuschließen.

Der Befehl zur Nicht-Indexierung kann alternativ auch über ein Feld im HTTP-Antwort-Header integriert werden. Hierzu fügt der Webmaster folgende Zeile ein:

X-Robots-Tag: noindex

Kombination mit follow oder nofollow

Die noindex Anweisung lässt sich optional um die Attribute follow oder nofollow ergänzen. Diese beziehen sich auf alle Verlinkungen, die auf der nicht indexierten Seite enthalten sind. Der Crawler folgt den Links auf der jeweiligen Seite, wenn der Befehl follow gesetzt wurde. Diese Befehlskombination wird häufig bei HTML Sitemaps eingesetzt. Deren eigene Indexierung macht selten Sinn, aus SEO Sicht ist die Sitemap jedoch wertvoll, da Google und Co über die einzelnen Links alle Unterseiten der Webpräsenz in wenigen Schritten erfassen können.

Der Follow-Befehl kann sich zudem bei paginierten Kategorie-Seiten oder Ergebnisseiten der internen Suchfunktion von Online-Shops für die SEO lohnen. Viele Website-Betreiber entscheiden sich wegen geringem Informationsgehalt und doppelten Inhalten dazu, solche Unterseiten nicht zu indexieren. Damit die Suchmaschinen trotzdem die einzelnen Produkte finden und indexieren, die in den Kategorien angeboten werden, ist das Attribut "follow" nützlich.

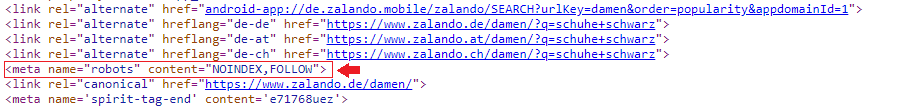

Auf diese Vorgehensweise setzt beispielsweise auch Zalando bei Unterseiten mit internen Suchergebnissen:

Screenshot mit “noindex, follow” im HTML Code von zalando.de

In diesem Zusammenhang sollte jedoch beachtet werden, dass Google den Links auf einer noindex Seite ab einem gewissen Zeitraum nicht mehr folgt, weshalb diese Vorgehensweise auf lange Sicht nur bedingt für die SEO zu empfehlen ist.

Das Attribut nofollow sorgt im Gegensatz zu follow dafür, dass die Crawler die Links auf der Unterseite nicht auswerten.

Unterschied zum Befehl “disallow” in der robots.txt-Datei

Über den Befehl disallow in der Datei robots.txt verbietet der Webmaster dem Bot, die dort definierten Bereiche zu crawlen. Der Befehl kommt beispielsweise bei Dateien wie Bildern in großen Datenbanken zum Einsatz, um wertvolles Crawling-Budget einzusparen. Bei Inhalten, die nicht indexiert werden sollen, ist der Befehl hingegen nicht sinnvoll. Zwar verbietet der Befehl das Crawlen einer bestimmter Seite, allerdings kann diese Seite dennoch im Index landen, wenn Backlinks von anderen Websites auf diese verweisen.

Aus diesem Grund sollten die Befehle noindex und disallow niemals auf einer Seite kombiniert werden. Da Crawler bei der Indexierung einer Website immer als erstes die Robots.txt-Datei aufrufen, erfassen sie den disallow Befehl zuerst und unterlassen infolgedessen das Crawling der jeweiligen Unterseiten. Dies hat jedoch zur Konsequenz, dass sie mögliche noindex Befehle auf diesen Seiten bereits im Vorfeld nicht erkennen können und die Unterseiten bei entsprechender Verlinkung über Backlinks dennoch in den Index aufnehmen. Soll eine Seite nicht in den Index der Suchmaschinen aufgenommen werden, muss dies daher allein über die Anweisung noindex realisiert werden.

Weiterführende Links

- https://support.google.com/webmasters/answer/93710?hl=de

- https://www.seo-suedwest.de/seo-wissen/tipps-und-tricks/35-onsite-optimierung/3392-noindex-oder-robots-txt-wann-ist-welches-instrument-das-richtige.html

- https://www.clicks.de/blog/warum-sollte-die-shopsuche-auf-noindex-nofollow-gestellt-werden